Forschung

Führen Sie heute innovative Forschungsprojekte durch, um die Herausforderungen von morgen zu bewältigen.

GereKa

[09/25 - 05/26]

Benutzerfreundliche 3D Gebäuderekonstruktion zur Bestandsaufnahme mittels Kamera

Projektträger Jülich - Energie und Klima – Energiesystem: Nutzung – Energieeffizienz in Gebäuden (ESN 1)

- 3D-Semantik-Segmentierung von Gebäuden mithilfe von BIM (Building Information Modeling)

- Entwicklung einer benutzerfreundlichen Smartphone-/Tablet-App

DIGI-PV

[07/23 - 06/26]

Digitale Planung und automatisierte Produktion von Gebäude-integrierter Photovoltaik

Teilvorhaben: Erfassung, Digitalisierung, Klassifizierung und Strukturierung von Gebäudeoberflächen

Vom Bundesministerium für Wirtschaft und Klimaschutz gefördertes Forschungsprojekt.

GreenAutoML4FAS

[03/23 - 02/26]

Automatisiertes Green-ML anhand des Anwendungsbeispiels Fahrerassistenzsysteme

Forschungsprojekt gefördert durch das Bundesministerium für Umwelt, Naturschutz, nukleare Sicherheit und Verbraucherschutz.

VISCODA arbeitet mit dem AI (Institut für Künstliche Intelligenz), dem TNT (Institut für Informationsverarbeitung) und dem IMS (Institut für Mikroelektronische Systeme) zusammen.

EVCS-Datensatz:

Veröffentlichungen:

- L. Chen, S. Südbeck, C. Riggers, T. Geib, K. Cordes, H. Broszio:

- „EVCS: A Benchmark for Fine-Grained Electric Vehicle Charging Station Detection”, GCPR 2025, angenommen

- K. Cordes, L. Chen, S. Südbeck, H. Broszio: „Online Optimization of Stereo Camera Calibration Accuracy”, 3D in Science & Applications (3D-iSA), 978-3-942709-34-7, S. 75-78, 2024, Preprint (pdf)

InFusion

[06/20 - 09/23]

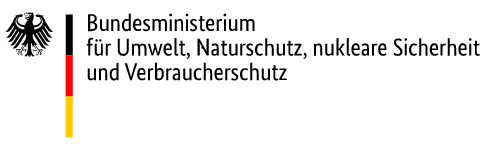

Cloud-Anwendung für zeitlich veränderliche Fahrbahnzustandsinformationen für verschiedene Fahrzeugklassen basierend auf fusionierten Fahrzeugdaten von Fahrzeugen verschiedener Klassen (LKW/PKW)

Erkennung, Lokalisierung und Klassifizierung von Straßenbedingungen in Echtzeit anhand der Frontkamera im Fahrzeug. Schätzung der fahrzeugspezifischen Straßenreibung durch Fusion mit Informationen aus anderen Sensoren (z. B. vibroakustische, meteorologische oder Traktionskontrollreaktionen). Ein cloudbasierter Dienst erhöht die Verkehrssicherheit und Effizienz für Fahrassistenz- und automatisierte Fahranwendungen.

- Pressemitteilung (Deutsch)

- Übersicht (Deutsch)

- Abschließende Demonstration: 16.01.24, 10–16 Uhr, Erich-Reinecke-Testbahn Contistraße 1, 29323 Wietze

Veröffentlichungen:

- K. Cordes and H. Broszio: "Camera-Based Road Snow Coverage Estimation", ICCV Workshop: roBustness and Reliability of Autonomous Vehicles in the Open-world (BRAVO), 2023, paper at CVF, paper at ieeexplore

- K. Cordes, C. Reinders, P. Hindricks, J. Lammers, B. Rosenhahn, H. Broszio: "RoadSaW: A Large-Scale Dataset for Camera-Based Road Surface and Wetness Estimation", CVPR Workshop on Autonomous Driving, 2022, paper at CVF, paper at ieeexplore

- Final Report: "InFusion - Cloud-Anwendung für zeitlich veränderliche Fahrbahnzustandsinformationen für verschiedene Fahrzeugklassen", 2023, doi: 10.2314/KXP:1912380390

IWAn

[01/21 - 06/23]

Interaktive Werkzeuge zur automatisierten 2D/3D-Annotation

Entwicklung interaktiver Methoden auf Basis von Computer Vision und maschinellem Lernen zur Vereinfachung und Beschleunigung der Annotation (z. B. Beschriftung) von Bilddaten.

Ziel ist es, mit minimaler Benutzerinteraktion hochpräzise Annotationen zu generieren. Die annotierten Daten dienen als Ground Truth für maschinelle Lernverfahren, die auf Anwendungen im Bereich des autonomen Fahrens abzielen.

KaBa

[05/21 - 03/23]

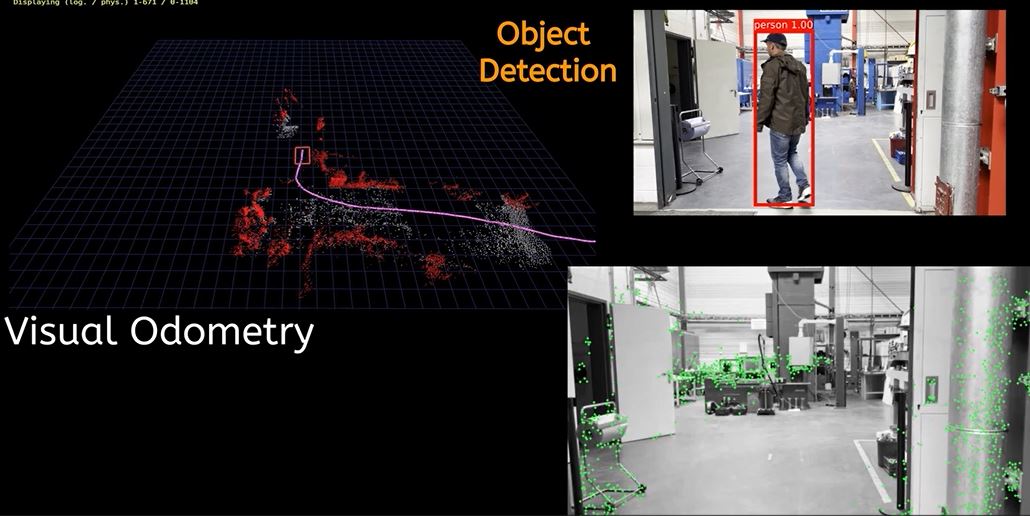

Kamerabasierte Bewegungsanalyse aller Verkehrsteilnehmer für automatisiertes Fahren

Dieses Projekt befasst sich mit der Bewegungsschätzung von Verkehrsteilnehmern, z. B. Autos und Fußgängern, anhand von monokularen Bildsequenzen. Zu diesem Zweck wird jede Kameraaufnahme einer panoptischen Segmentierung unterzogen, um Objektinstanzen von Verkehrsteilnehmern zu extrahieren.

Anschließend werden die 3D-Informationen (Position, Ausrichtung und Form) der erkannten Verkehrsteilnehmer geschätzt. Erfasste Objektinstanzen werden über mehrere Bilder hinweg durch die Zusammenführung ihrer räumlichen Konsistenz in 2D und 3D miteinander verknüpft. Das Ergebnis ist die Bewegung aller erfassten Verkehrsteilnehmer, was für die Planungsphase des automatisierten Fahrens von grundlegender Bedeutung ist.

Dieses Projekt wurde mit Mitteln des Europäischen Fonds für regionale Entwicklung gefördert.

Scene Reconstruction from Video

[aktuell]

Kamerabasierte Bewegungsanalyse aller Verkehrsteilnehmer für automatisiertes Fahren

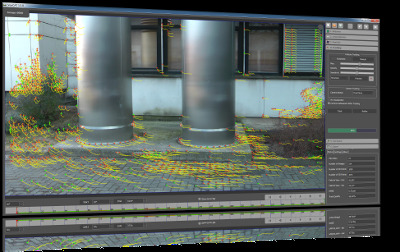

Für die Produkte VooCAT/CineCAT werden verschiedene Algorithmen für die Kamerakalibrierung, das Tracking, die Struktur aus Bewegung und die Videosegmentierung entwickelt. Die Grundlage für die Szenenschätzung ist die Verwendung entsprechender Bildmerkmale, die aus einer 3D-Struktur entstehen, die auf verschiedene Kamerabildebenen abgebildet wird. Durch Verwendung eines statistischen Fehlermodells, das die Fehler in der Position der erkannten Merkmalspunkte beschreibt, kann ein Maximum-Likelihood-Schätzer formuliert werden, der gleichzeitig die Kameraparameter und die 3D-Positionen der Bildmerkmale schätzt.

Der Kamerapfad, die Videosegmentierung und die rekonstruierte Szene sind für die Integration virtueller Objekte in das Video unerlässlich. Die Punktwolke wird für 3D-Messungen verwendet, z. B. für Entfernungen zu oder zwischen verschiedenen Objekten der Szene.

Veröffentlichte Videos [YouTube]:

- Echtzeit-Visuelle Odometrie & Rekonstruktion

- Beispielvideo zu Augmentationsergebnissen

- 3D-Rekonstruktion aus monokularem Video

- Tutorial-Video

Veröffentlichungen:

- K. Cordes, H. Broszio: „Accuracy Evaluation and Improvement of the Calibration of Stereo Vision Datasets”, ECCV - VCAD-Workshop, 2024, Vorabdruck (pdf)

- K. Cordes, H. Broszio: „Micro Maneuvers: Obstacle Detection for Standing Vehicles using Monocular Camera”, IEEE 25th International Conference on Intelligent Transportation Systems (ITSC), S. 3861-3866, 2022

Patente:

- "Method for detecting curbs in the vehicle environment", ("Verfahren zur Erfassung von im Fahrzeugumfeld befindlichen Bordsteinen"), Maciej Korzec, Hellward Broszio, Matthias Narroschke, Nikolaus Meine, DE102016215840A1, 2018-03-01

- "Method of inherent shadow recognition", ("Verfahren zur Eigenschattenerkennung"), Daniel Liebehenschel, Maciej Korzec, Hellward Broszio, Kai Cordes, Carolin Last, DE102016216462A1, 2018-03-01

- "Method for continuous estimation of driving surface plane of motor vehicle" ("Verfahren und Vorrichtung zur Schätzung einer Fahrbahnebene und zur Klassifikation von 3D-Punkten"), Andreas Haja, Hellward Broszio, Nikolaus Meine, DE102011118171A1, 2013-05-16

- "Method for determining e.g. wall in rear area of passenger car during parking" ("Verfahren zur Bestimmung von Objekten in einer Umgebung eines Fahrzeugs"), Andreas Haja, Hellward Broszio, Nikolaus Meine, DE102011113099A1, 2013-03-14

- "Method for determining angle between towing vehicle and trailer" ("Verfahren und Vorrichtung zur Bestimmung eines Winkels zwischen einem Zugfahrzeug und einem daran gekoppelten Anhänger"), Andreas Haja, Hellward Broszio, Nikolaus Meine, DE102011113197A1, 2013-03-14

- "Method for detecting obstacle in car surroundings" ("Verfahren und Vorrichtung zur Detektion mindestens eines Hindernisses in einem Fahrzeugumfeld"), Hellward Broszio, Andreas Haja, Nikolaus Meine, DE102010009620A1, 2011-09-01

VooCAT

Real-time Visual Odometry

MicroManeuvers

IdenT

[02/20 - 04/23]

Identifikation dynamik- und sicherheitsrelevanter Trailerzustände für automatisiert fahrende Lastkraftwagen

Die dynamischen Eigenschaften eines Lkw werden in hohem Maße von seinem Anhänger bestimmt. Dennoch wird der Anhänger in aktuellen Lkw-Sensorsystemen kaum berücksichtigt.

Das Ziel von IdenT ist die Entwicklung eines intelligenten Anhänger-Sensornetzwerkes und einer cloudbasierten Datenplattform für die zuverlässige Echtzeit-Schätzung des Zustands von Anhängerkomponenten, die für automatisierte Fahranwendungen entscheidend sind. Mithilfe einer nach hinten gerichteten Kamera liefert VISCODA seinen Projektpartnern eine hochpräzise visuelle Odometrie und eine geometrisch rekonstruierte Szene für die Sensorfusion an Bord und in der Cloud.

Durch eine Kombination aus regelbasierten (geometrischen) und datengesteuerten (maschinelles Lernen) Algorithmen erkennt und lokalisiert VISCODA zusätzlich Verkehrsteilnehmer hinter dem Heck des Anhängers.

RaSar

[01/18 - 12/20]

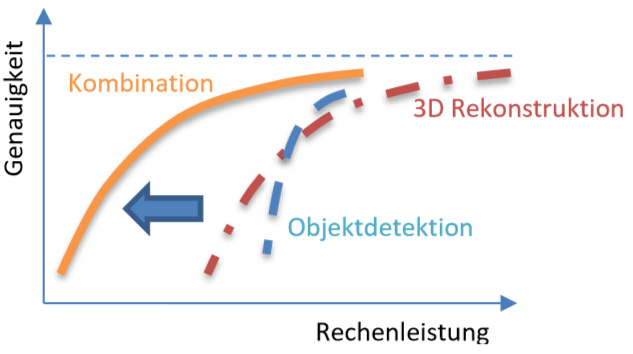

Ressourcenadaptive Szenenanalyse und -rekonstruktion

Forschungsprojekt in Zusammenarbeit mit dem Institut für Informationsverarbeitung (Leibniz Universität Hannover / LUH) mit dem Ziel einer optimalen Genauigkeit bei der 3D-Szenenrekonstruktion und der Zuverlässigkeit der Objekterkennung unter Berücksichtigung von Ressourcenbeschränkungen wie der hardwarespezifischen Rechenleistung.

Dieses Projekt wurde mit Mitteln des Europäischen Fonds für regionale Entwicklung gefördert.

5GCAR

[06/17 - 07/19]

Kooperative und vernetzte V2X-Anwendungen treiben weitere Verbesserungen von Fahrerassistenzsystemen (ADAS) und automatisiertem Fahren voran. Für die abschließenden Demonstrationen im Rahmen des 5GCAR-Projekts wurden drei Anwendungsfallklassen ausgewählt und Vertreter für jede Klasse identifiziert. Die Klassen sind „Kooperatives Manövrieren“, „Kooperative Wahrnehmung“ und „Kooperative Sicherheit“.

VISCODA entwickelte Multiple Object Tracking (MOT) für den Anwendungsfall „Lane Merge Coordination“ (Spurwechselkoordination).

Darüber hinaus werden Long-Range Sensor Sharing, See-through und Network-assisted Vulnerable Road User (VRU) Protection vorgestellt. Die abschließende Demonstration fand auf der UTAC-Teststrecke in der Nähe von Paris statt.

5GCAR ist ein von der Europäischen Kommission finanziertes H2020-5G-PPP-Phase-2-Projekt.

Projekt-Website:

Projekt-Flyer:

Veröffentlichte Videos:

- 5GCAR final demonstration

- 5GCAR pre-demonstration (demo video for MWC 2019)

- Explanation of 5GCAR use cases (demo video for MWC 2018)

Veröffentlichungen:

- K. Cordes, H. Broszio, H Wymeersch, S Saur, F Wen, Nil Garcia, Hyowon Kim: "Radio‐Based Positioning and Video‐Based Positioning",

https://doi.org/10.1002/9781119692676.ch8, Wiley, April 2021

Book Chapter at ieeexplore - K. Cordes and H. Broszio: "Vehicle Lane Merge Visual Benchmark",

International Conference on Pattern Recognition (ICPR), IEEE, pp. 715-722, 2021

Supplementary Video, Poster, Benchmark,

Paper at ieeexplore - K. Antonakoglou, N. Brahmi, T. Abbas, A.E. Fernandez Barciela, M. Boban, K. Cordes, M. Fallgren, L. Gallo, A. Kousaridas, Z. Li, T. Mahmoodi, E. Ström, W. Sun, T. Svensson, G. Vivier, J. Alonso-Zarate:"On the Needs and Requirements Arising from Connected and Automated Driving", J. Sens. Actuator Netw. 2020, 9(2):24.

OpenAccess: abstract, html, pdf - K. Cordes, N.Nolte, N. Meine, and H. Broszio: "Accuracy Evaluation of Camera-based Vehicle Localization", International Conference on Connected Vehicles and Expo (ICCVE), IEEE, pp. 1-7, Nov. 2019

Paper at ieeexplore - "The 5GCAR Demonstrations", Sep. 2019

Deliverable D5.2 (pdf) - B. Cellarius, K. Cordes, T. Frye, S. Saur, J. Otterbach, M. Lefebvre, F. Gardes, J. Tiphène, M. Fallgren: "Use Case Representations of Connected and Automated Driving", European Conference on Networks and Communications (EuCNC), June 2019

Extended abstract (pdf), Poster (pdf) - K. Cordes and H. Broszio: "Constrained Multi Camera Calibration for Lane Merge Observation" International Conference on Computer Vision Theory and Applications (VISAPP), SciTePress, pp. 529-536, Feb. 2019

Paper preprint (pdf), Poster (pdf) - "5GCAR Demonstration Guidelines", May 2018, Deliverable D5.1

- M. Fallgren, M. Dillinger, A. Servel, Z. Li, B. Villeforceix, T. Abbas, N. Brahmi, P. Cuer, T. Svensson, F. Sanchez, J. Alonso-Zarate, T. Mahmoodi, G. Vivier, M. Narroschke: "On the Fifth Generation Communication Automotive Research and Innovation Project 5GCAR - The Vehicular 5G PPP Phase 2 Project",

European Conference on Networks and Communications (EuCNC), June 2017

Extended abstract (pdf)

Objektbewegungs-schätzung

[aktuell]

Zur Schätzung von Bewegungsmodellen bewegter Objekte in Videos wird eine Bewegungssegmentierungstechnik verwendet. Bei der Bewegungssegmentierung werden die Merkmalsverläufe in einer Bildsequenz verschiedenen Bewegungen zugeordnet. Hypergraphbasierte Ansätze verwenden einen spezifischen Graphen, um Ähnlichkeiten höherer Ordnung für die Schätzung von Bewegungsklustern zu berücksichtigen. Sie folgen dem Konzept der Hypothesenbildung und -validierung.

Unser Ansatz verwendet ein einfaches, aber effektives Modell zur Einbeziehung bewegungskohärenter Affinitäten. Die aus dem resultierenden Hypergraphen generierten Hypothesen führen zu einer deutlichen Verringerung des Segmentierungsfehlers.

Veröffentlichungen

- K. Cordes, C. Ray’onaldo, H. Broszio: „Motion-Coherent Affinities for Hypergraph Based Motion Segmentation”, Internationale Konferenz zur Computeranalyse von Bildern und Mustern (CAIP), Springer LNCS, S. 121–132, August 2017